“Wir suchen konkrete Beispiele für die Diskriminierung durch Algorithmen in Deutschland.”

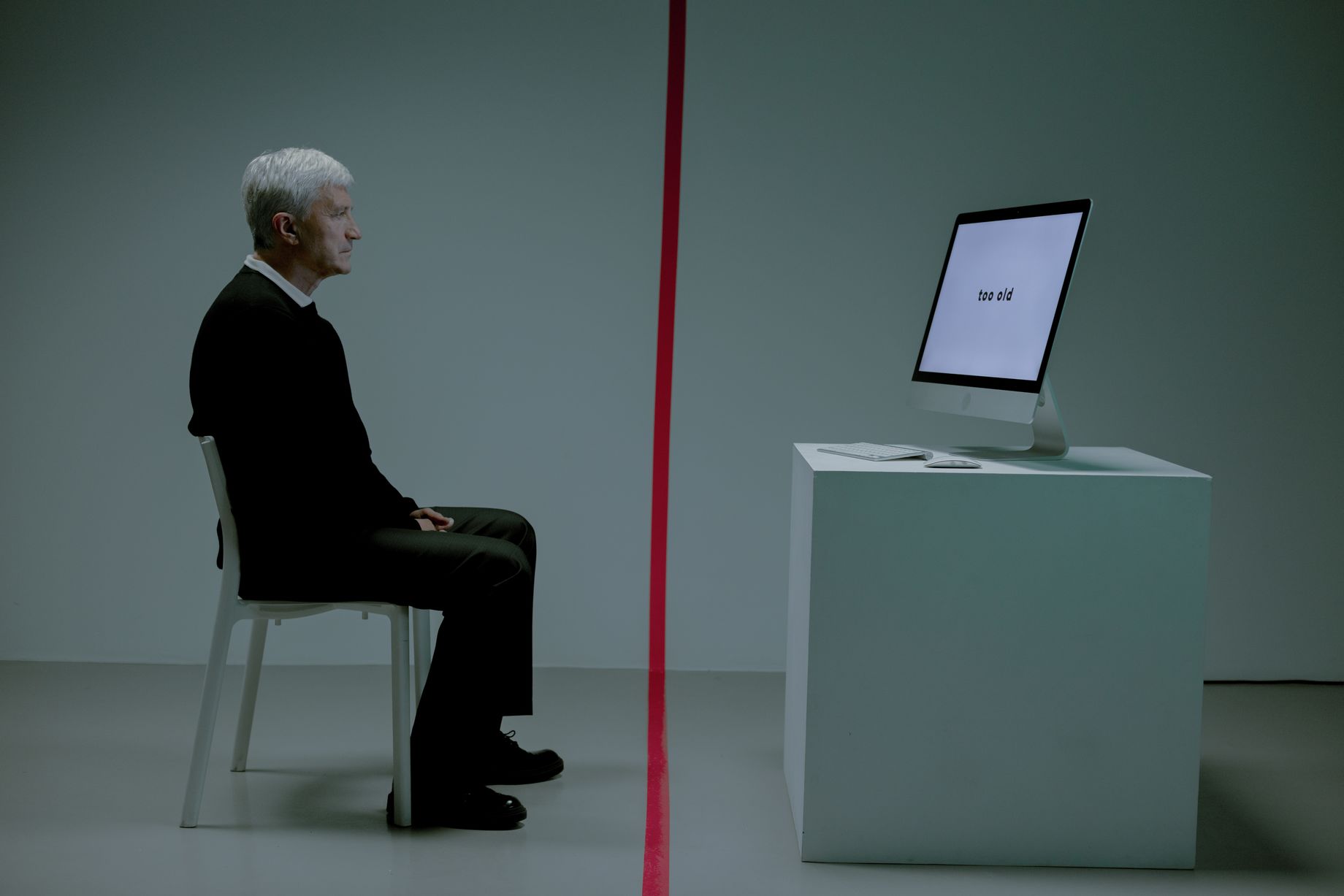

Automatisierte Systeme werden oft in der Hoffnung eingesetzt, dass sie Entscheidungen objektiver treffen als Menschen. Warum geht aber gerade von ihnen ein großes Risiko aus, dass sie Betroffene diskriminieren oder ungleich behandeln?

Leider zeigt sich immer wieder, dass automatisierte Systeme direkt oder indirekt diskriminierende Ergebnisse produzieren. In der Entwicklung und Anwendung von automatisierten Systemen treffen Menschen an vielen Punkten Entscheidungen und lassen so – meist unbewusst – ihre Voreingenommenheiten in die Systeme einfließen. Das kann am Ende zu diskriminierenden Ergebnissen führen. Wenn so ein System allgemein eingeführt wird, betrifft das jedoch breite Bevölkerungsschichten. Wenn zum Beispiel bei einer Software zur Personalauswahl Frauen benachteiligt werden, dann werden Frauen in jeder Entscheidung benachteiligt, die auf dieser Software basiert. Die gesamtgesellschaftlichen Auswirkungen können daher sehr groß sein.

Welche konkreten Beispiele gibt es für Diskriminierung durch automatisierte Systeme?

Bei einem sehr bekannten Beispiel aus den USA stellte sich heraus, dass geläufige Gesichtserkennungssoftware von großen Firmen schwarze Frauen viel schlechter identifizieren als weiße Männer. Die erhöhte Fehlerquote war alarmierend, weil die Software teilweise von der US-amerikanischen Polizei eingesetzt wurde. Ein anderes bekanntes Beispiel betrifft eine Bewerbungssoftware, die Einstellungsprozesse effizienter gestalten sollte. Noch in der Testphase der Software stellte sich heraus, dass durch die Empfehlungen der Software Frauen diskriminiert wurden, da ihre Lebensläufe aussortiert wurden. Versuche, diese Benachteiligung zu korrigieren, hatten keinen Erfolg – die Software wurde eingestellt.

Kennen Sie auch Fälle in Deutschland?

Aus Deutschland sind bisher wenige Fälle bekannt, und das, obwohl auch hierzulande automatisierte Systeme verstärkt eingesetzt werden. Deswegen bemüht sich das Projekt AutoCheck ganz besonders darum, Fallbeispiele aus Deutschland zu finden. Fallbeispiele helfen uns enorm dabei, die derzeitige Situation abzubilden, das Thema anschaulicher zu machen und Menschen für die Risiken von automatisierten Entscheidungssystemen für sie selbst und andere zu sensibilisieren.

Dafür ist es uns wichtig, gerade mit Einrichtungen der Sozialen Arbeit und der Antidiskriminierungs-Beratung in Kontakt zu kommen. Gerade dort treffen wir auf Menschen, die einem besonders hohen Risiko für gesellschaftliche Ungleichbehandlung ausgesetzt sind. Diskriminierungen über automatisierte Entscheidungssysteme sind allerdings nicht leicht erkennbar. Wir bieten Schulungen und Handreichungen an, die dabei unterstützen, mit entsprechenden Risiken umzugehen. Konkrete Fallbeispiele oder Verdachtsfälle können uns dabei helfen, diese Angebote weiter auszubauen und wir freuen uns über entsprechende Hinweise.

Das Interview führte Kay Schulze

Das Projekt #GleichImNetz hat in Zusammenarbeit mit AlgorithmWatch einen Aufruf veröffentlicht: Sollten Sie im Rahmen Ihrer Arbeit auf Hinweise für Diskriminierung durch automatisierte Entscheidungssysteme gestoßen sein, melden Sie sich gerne bei AlgorithmWatch. Für vertiefende Informationen folgen Sie bitte den Links im Beitrag.

Und hier finden Sie weitere Informationen zum Digi-Dienstag.

Eckpunkte zu Digitaler Teilhabe

Nicht nur Algorithmen können Segen und Fluch zugleich sein. Digitale Kommunikation insgesamt bietet viel Potential für mehr Teilhabe zahlreicher Bevölkerungsgruppen, setzt aber ebenso neue Hürden. Der Paritätische Gesamtverband hat ein Positionspapier mit Eckpunkten zur digitalen Teilhabe für alle verabschiedet. Digitale Teilhabe beginnt vielfach ganz grundlegend mit der Verfügbarkeit der nötigen Hard- und Software und der Netzzugänge sowie der Kompetenzen, diese souverän zu nutzen. Auch die vorgeschriebenen Maßnahmen zur Barrierefreiheit digitaler Angebote werden häufig nicht erfüllt. Nicht zuletzt mit der digitalen Umsetzung staatlicher Leistungen drohen digitale Klüfte und damit auch soziale Klüfte sich zu vertiefen. Vielfach ist es die Freie Wohlfahrtspflege, die - neben ihrem eigenen digitalen Wandel - dem entgegensteuert, für ihre Klient*innen eine Mittlerinnenfunktion zu digitalen Angeboten übernimmt und Starthilfe leistet. Anders als bei Unternehmen ist bisher jedoch keine flächendeckende staatliche Unterstützung zur Digitalisierung gemeinnütziger Organisationen gegeben.